Már tudjuk, hogy a nagy hadron ütköző (LHC) lesz a legnagyobb, legdrágább fizikai kísérlet, amelyet az emberiség valaha végzett. A relativista részecskék ütközése olyan energiákon, amelyeket korábban elképzelni sem lehetett (az évtized végére a 14 TeV jelig), millió millió részecske keletkezik (ismert és még felfedezésre váró), amelyeket nyomon kell követni és hatalmas részecskedetektorokkal kell jellemezni. Ez a történelmi kísérlet hatalmas adatgyűjtést és tárolást igényel, újraírva az adatkezelési szabályokat. Öt másodpercenként az LHC ütközések DVD-értékű adatnak felelnek meg, azaz másodpercenként egy gigabájt adat előállítási sebessége. A perspektíva szempontjából egy átlagos, nagyon jó kapcsolattal rendelkező háztartási számítógép másodpercenként egy vagy két megabájt sebességgel tudja letölteni az adatokat (ha nagyon szerencsés vagy! 500 kilobájt / másodperc sebességgel jár). Tehát az LHC mérnökei új típusú adatkezelési módszert fejlesztettek ki, amely tárolhatja és terjesztheti petabájt (millió gigabájt) adatot az LHC munkatársai számára világszerte (anélkül, hogy öregszik és szürke lesz, miközben várják a letöltést).

1990-ben az Európai Nukleáris Kutatási Szervezet (CERN) forradalmasította életmódunkat. Az előző évben Tim Berners-Lee, a CERN fizikus javaslatot írt az elektronikus információkezelésre. Előterjesztette azt az elképzelést, miszerint az információkat könnyen tovább lehet továbbítani az interneten keresztül, hipertextnek hívva. Az idő múlásával a Berners-Lee és Robert Cailliau, a CERN rendszermérnöke is együttműködött, egyetlen információs hálózatot hozott létre, hogy segítse a CERN tudósait az együttműködésben és az információk megosztásában személyi számítógépükről anélkül, hogy nehézkes tárolóeszközökre kellene mentenie. A hipertext lehetővé tette a felhasználók számára a böngészést és a szövegek megosztását a weboldalakon a hiperhivatkozások. Berners-Lee ezután létrehozott egy böngésző-szerkesztőt, és hamarosan rájött, hogy ez a kommunikáció új formája nagyszámú ember számára megosztható. 1990 májusáig a CERN tudósai ezt az új együttműködési hálózatot hívták a Világháló. Valójában a CERN volt a felelős a világ első weboldaláért: http://info.cern.ch/, és a webes konzorcium weboldalán található egy korai példa erre a webhelyre.

A CERN tehát nem idegen az adatkezelésnek az interneten keresztül, de a vadonatúj LHC speciális kezelést igényel. Amint azt David Bader, a Georgia Georgia Institute of Technology nagyteljesítményű számítástechnikai ügyvezető igazgatója hangsúlyozta, az internet által megengedett jelenlegi sávszélesség hatalmas szűk keresztmetszetet jelent, ami az adatmegosztás egyéb formáit kívánatosabbá teszi. „Ha megnézem az LHC-t, és mit csinál a jövőért, akkor az egyetlen dolog, amelyet a web nem tudott megtenni, egy fenomenális adatgazdag kezelés"- mondta, ami azt jelenti, hogy könnyebb menteni a nagy adatkészleteket terabyte-os merevlemezekre, majd azokat postán elküldeni az együttműködőknek. Noha a CERN foglalkozott az adatmegosztás együttműködő jellegével a világhálón, az LHC által előállított adatok könnyen túlterhelik a jelenleg elérhető kis sávszélességeket.

Ezért lett az LHC Computing Grid kialakítva. A rács nagyméretű LHC adatkészlet-előállítást lépcsőben kezeli, az első (0. szint) a CERN helyén található, a svájci Genf közelében. A 0 szint a hatalmas párhuzamos számítógépes hálózatból áll, amely 100 000 fejlett CPU-t tartalmaz, amelyeket felállítottak az LHC által kiszivattyúzott nyers adatok (bináris kód 1 és 0) azonnali tárolására és kezelésére. Érdemes megjegyezni, hogy az érzékelők nem érzékelik az összes részecske-ütközést, csak nagyon kis részet lehet kimutatni. Bár csak viszonylag kis számú részecskét lehet detektálni, ez továbbra is hatalmas eredményt eredményez.

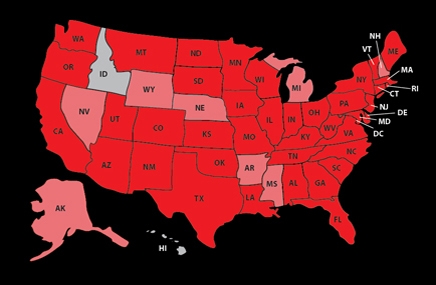

A 0. szint a kezdeti adatmennyiségeket kezeli úgy, hogy robbantják azokat egy 10 gigabites / másodperces száloptikai vonalon keresztül 11 1. szint telek Észak-Amerikában, Ázsiában és Európában. Ez lehetővé teszi olyan munkatársak számára, mint a New York-i Brookhaven Nemzeti Laboratórium Relativistic Heaven Ion Collider (RHIC) elemzése az ALICE kísérletből származó adatok elemzésére, összehasonlítva az LHC ólom-ion ütközések eredményeit a saját nehézionok ütközési eredményeivel.

A Tier 1 nemzetközi számítógépektől az adatkészletek csomagolódnak és elküldésre kerülnek a 140-re 2. sor számítógépes hálózatok az egyetemeken, laboratóriumokban és magánvállalkozásokban a világ minden tájáról. A tudósok ezen a ponton férnek hozzá az adatkészletekhez, hogy elvégezzék a nyers bináris kódból a részecskék energiájáról és a pályákról hasznos információkké való átalakítást.

A rétegrendszer minden rendben és jó, de nem működne rendkívül hatékony „köztes szoftver” típusú szoftver nélkül. Az adatokhoz való hozzáférés megkísérlésekor a felhasználónak információt kell kérnie, amely az adatok petatabátusaiban eloszlik a különböző szerverekön, különböző formátumokban. Az úgynevezett nyílt forrású köztes szoftver platform Globus hatalmas felelősséggel tartozik a szükséges információk zökkenőmentes összegyűjtése, mintha ezek az információk már a kutató számítógépén ülnek.

A rétegrendszer, a gyors kapcsolat és az ötletes szoftver kombinációja bővíthető az LHC projekten túl. Egy olyan világban, ahol minden igényre válik, ez a fajta technológia teszi lehetővé az internetet átlátszó a végfelhasználónak. Azonnal elérhető lesz minden, a bolygó másik oldalán végzett kísérletekből származó adatokig, a nagyfelbontású filmek megtekintéséig, anélkül hogy várnánk a letöltési folyamatjelző sávot. Hasonlóan a Berners-Lee által a HTML találmányához, az LHC Computing Grid forradalmasíthatja az Internet használatát.

Források: Scientific American, CERN